opensearch

OpenSearch — это распределённая поисковая и аналитическая система, основанная на Apache Lucene. После добавления данных в OpenSearch вы можете выполнять полнотекстовый поиск с полным набором ожидаемых функций: поиск по полям, поиск по нескольким индексам, усиление полей, ранжирование результатов по релевантности, сортировка по полям и агрегация результатов.

Неудивительно, что разработчики часто используют поисковые системы, такие как OpenSearch, в качестве бэкенда для поисковых приложений — например, для Википедии или интернет-магазинов. Он обеспечивает отличную производительность и может масштабироваться в зависимости от потребностей приложения.

Ещё один популярный, но менее очевидный сценарий использования — анализ логов. В этом случае логи приложения загружаются в OpenSearch, а мощные функции поиска и визуализации помогают выявлять проблемы. Например, неисправный веб-сервер может выдавать ошибку 500 в 0,5% случаев, что сложно заметить без графика в реальном времени, отображающего все HTTP-статусы за последние четыре часа. С помощью OpenSearch Dashboards можно создавать такие визуализации на основе данных из OpenSearch.

Компоненты

OpenSearch — это не только поисковый движок. В его состав также входят:

- OpenSearch Dashboards — интерфейс для визуализации данных OpenSearch.

- Data Prepper — серверный сборщик данных, способный фильтровать, обогащать, преобразовывать, нормализовать и агрегировать данные для последующего анализа и визуализации.

- Клиенты — языковые API, позволяющие взаимодействовать с OpenSearch на популярных языках программирования.

Сценарии использования

OpenSearch поддерживает множество сценариев, например:

- Наблюдаемость (Observability) — визуализация событий на основе данных с помощью Piped Processing Language (PPL) для исследования, обнаружения и запросов к данным в OpenSearch.

- Поиск — выбор оптимального метода поиска для вашего приложения: от стандартного лексического поиска до диалогового поиска на базе машинного обучения (ML).

- Машинное обучение — интеграция ML-моделей в приложения на OpenSearch.

- Анализ безопасности — расследование, обнаружение, анализ и реагирование на угрозы, которые могут повлиять на успех организации и её онлайн-операции.

Следующие шаги

- Ознакомьтесь с [Введением в OpenSearch](Introduction to OpenSearch), чтобы изучить основные концепции OpenSearch.

1 - Введение в Opensearch

OpenSearch — это распределённая поисковая и аналитическая система, которая поддерживает различные сценарии использования: от реализации поисковой строки на веб-сайте до анализа данных безопасности для выявления угроз.

Введение в OpenSearch

Термин распределённая означает, что OpenSearch можно запускать на нескольких компьютерах. Поиск и аналитика подразумевают, что после загрузки данных в OpenSearch их можно искать и анализировать. Независимо от типа данных, их можно хранить и исследовать с помощью OpenSearch.

Документ

Документ — это единица хранения информации (текстовой или структурированной). В OpenSearch документы хранятся в формате JSON.

Документ можно представить несколькими способами:

- В базе данных студентов документ может представлять одного учащегося.

- При поиске информации OpenSearch возвращает документы, соответствующие запросу.

- Документ аналогичен строке в традиционной реляционной базе данных.

Например, в школьной базе данных документ может представлять студента и содержать следующие данные:

| ID |

Имя |

GPA |

Год выпуска |

| 1 |

John Doe |

3.89 |

2022 |

Вот как этот документ выглядит в формате JSON:

{

"name": "John Doe",

"gpa": 3.89,

"grad_year": 2022

}

Вы узнаете, как назначаются идентификаторы документов, в разделе Индексация документов.

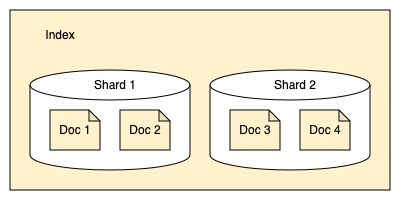

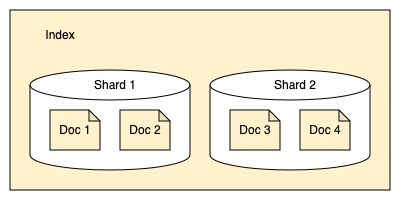

Индекс

Индекс — это коллекция документов.

Индекс можно рассматривать несколькими способами:

- В базе данных студентов индекс представляет всех учащихся в базе.

- При поиске информации запрос выполняется к данным внутри индекса.

- Индекс соответствует таблице в традиционной реляционной базе данных.

Например, в школьной базе данных индекс может содержать всех студентов школы:

| ID |

Имя |

GPA |

Год выпуска |

| 1 |

John Doe |

3.89 |

2022 |

| 2 |

Jonathan Powers |

3.85 |

2025 |

| 3 |

Jane Doe |

3.52 |

2024 |

| … |

… |

… |

… |

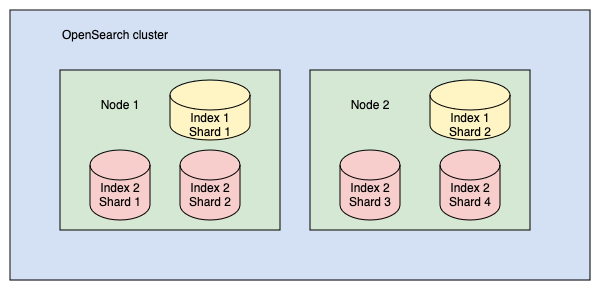

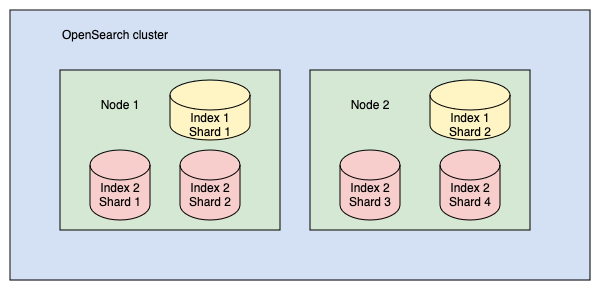

Кластеры и узлы

OpenSearch разработан как распределённая поисковая система, что означает возможность работы на одном или нескольких узлах — серверах, хранящих данные и обрабатывающих поисковые запросы. Кластер OpenSearch — это совокупность таких узлов.

Вы можете запустить OpenSearch локально на ноутбуке (системные требования минимальны), но также можно масштабировать кластер до сотен мощных серверов в дата-центре.

В одноузловом кластере (например, развёрнутом на ноутбуке) одна машина выполняет все задачи:

- управляет состоянием кластера,

- индексирует данные и обрабатывает поисковые запросы,

- выполняет предварительную обработку данных перед индексацией.

Однако по мере роста кластера обязанности можно распределить:

- Узлы с быстрыми дисками и большим объёмом ОЗУ подходят для индексации и поиска.

- Узлы с мощными CPU, но малым дисковым пространством, могут управлять состоянием кластера.

В каждом кластере выбирается главный узел (cluster manager node), который координирует операции на уровне кластера (например, создание индекса). Узлы взаимодействуют между собой: если запрос направлен к одному узлу, он может запрашивать данные у других узлов, агрегировать их ответы и возвращать итоговый результат.

Подробнее о других типах узлов см. в разделе Формирование кластера.

Шарды (Shards)

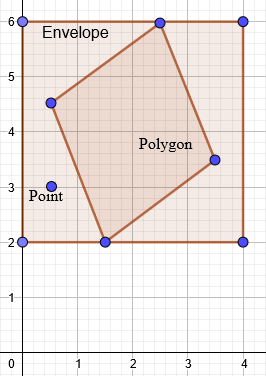

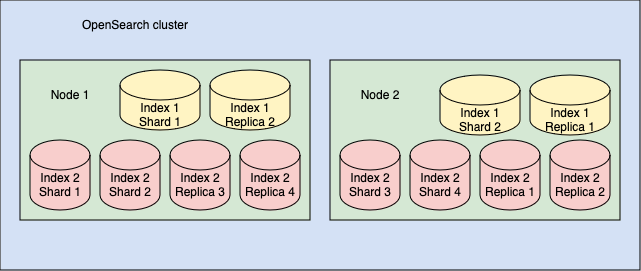

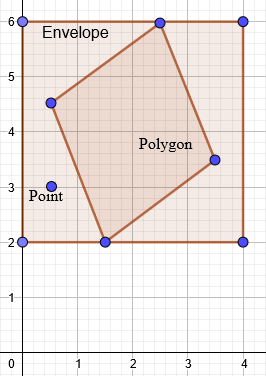

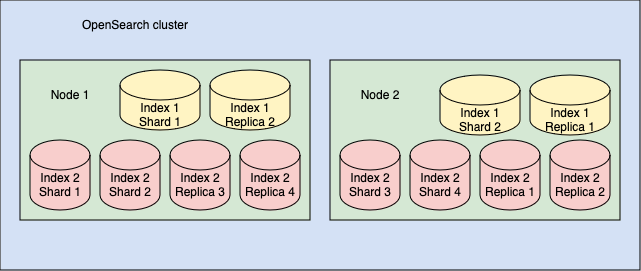

OpenSearch разделяет индексы на шарды. Каждый шард хранит подмножество всех документов индекса, как показано на следующей диаграмме:

Шарды используются для равномерного распределения данных между узлами кластера. Например:

- Индекс размером 400 ГБ может быть слишком большим для обработки на одном узле

- Если разделить его на 10 шардов по 40 ГБ каждый, OpenSearch сможет распределить их между 10 узлами

- Каждый шард будет обрабатываться независимо

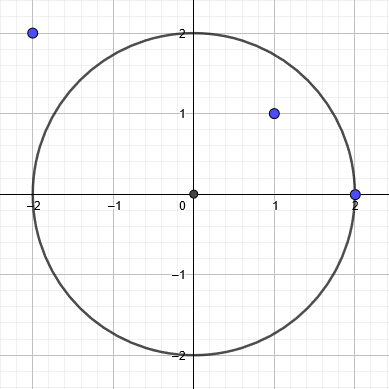

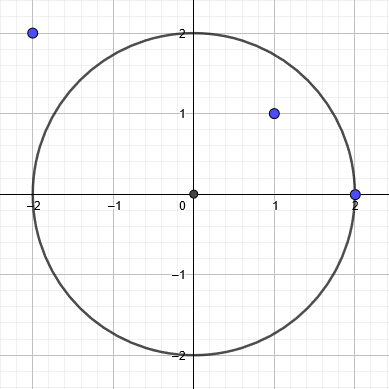

Рассмотрим кластер с двумя индексами:

- Индекс 1 разделён на 2 шарда

- Индекс 2 разделён на 4 шарда

Эти шарды распределены между двумя узлами, как показано на схеме:

Хотя каждый шард является частью индекса OpenSearch, технически он представляет собой полноценный индекс Lucene. Это важно учитывать, потому что:

- Каждый экземпляр Lucene - это отдельный процесс

- Каждый процесс потребляет ресурсы CPU и памяти

- Слишком большое количество шардов может перегрузить кластер

Рекомендации по работе с шардами:

- Не стоит разделять индекс на чрезмерное количество шардов

- Например, деление индекса 400 ГБ на 1000 шардов создаст ненужную нагрузку

- Оптимальный размер шарда - от 10 до 50 ГБ

Первичные и реплицированные шарды

В OpenSearch шарды могут быть двух типов:

- Первичные (primary) - оригинальные шарды

- Реплики (replica) - копии шардов

По умолчанию OpenSearch создаёт по одной реплике для каждого первичного шарда. Таким образом:

- Если индекс разделён на 10 шардов, будет создано 10 реплик

- В примере из предыдущего раздела (2 индекса):

- Индекс 1: 2 шарда + 2 реплики

- Индекс 2: 4 шарда + 4 реплики

Функции реплик:

- Резервное копирование на случай сбоя узла

- Реплики размещаются на разных узлах от первичных шардов

- Ускорение обработки поисковых запросов

- Для нагрузок с интенсивным поиском можно создать несколько реплик

Инвертированный индекс

OpenSearch использует структуру данных под названием инвертированный индекс, которая:

- Сопоставляет слова с документами, где они встречаются

- Пример для двух документов:

- Документ 1: “Красота в глазах смотрящего”

- Документ 2: “Красавица и чудовище”

Инвертированный индекс будет выглядеть так:

| Слово |

Документы |

| красота |

1 |

| в |

1 |

| глазах |

1 |

| смотрящего |

1 |

| красавица |

2 |

| и |

2 |

| чудовище |

2 |

Дополнительно OpenSearch хранит:

- Позиции слов в документах

- Это позволяет выполнять поиск по фразам

Релевантность

При поиске OpenSearch:

- Сопоставляет слова запроса с документами

- Присваивает каждому документу оценку релевантности

Факторы оценки:

- Частота термина (TF):

- Чем чаще слово встречается в документе, тем выше оценка

- Обратная частота документа (IDF):

- Редкие слова имеют больший вес (например, “аксолотль” vs “синий”)

- Нормализация по длине:

- Более короткие документы получают преимущество

OpenSearch использует алгоритм BM25 для расчёта релевантности и сортировки результатов.

Следующие шаги

Узнайте, как быстро установить OpenSearch, в разделе Быстрый старт установки.

1.1 - Быстрый старт установки

Для быстрого запуска OpenSearch и OpenSearch Dashboards используйте контейнеры Docker.

Для быстрого запуска OpenSearch и OpenSearch Dashboards используйте контейнеры Docker. Полное руководство по установке доступно в разделе Установка и обновление OpenSearch.

Предварительные требования:

- Установите Docker и Docker Compose на локальную машину

Запуск кластера

-

Настройка системы

Перед запуском рекомендуется:

- Отключить подкачку памяти для повышения производительности:

- Увеличить максимальное количество memory maps:

Добавьте строку:

Примените изменения:

-

Получение файла конфигурации

Загрузите образец docker-compose.yml:

- Через cURL:

curl -O https://raw.githubusercontent.com/opensearch-project/documentation-website/3.1/assets/examples/docker-compose.yml

- Через wget:

wget https://raw.githubusercontent.com/opensearch-project/documentation-website/3.1/assets/examples/docker-compose.yml

-

Запуск кластера

Перейдите в директорию с файлом и выполните:

Проверьте статус контейнеров:

Ожидаемый вывод:

NAME COMMAND SERVICE STATUS PORTS

opensearch-dashboards "./opensearch-dashbo…" opensearch-dashboards running 0.0.0.0:5601->5601/tcp

opensearch-node1 "./opensearch-docker…" opensearch-node1 running 0.0.0.0:9200->9200/tcp, 9300/tcp, 0.0.0.0:9600->9600/tcp, 9650/tcp

opensearch-node2 "./opensearch-docker…" opensearch-node2 running 9200/tcp, 9300/tcp, 9600/tcp, 9650/tcp

-

Проверка работы

Выполните тестовый запрос к API:

curl https://localhost:9200 -ku admin:ВАШ_ПАРОЛЬ

Успешный ответ:

{

"name": "opensearch-node1",

"cluster_name": "opensearch-cluster",

"version": {

"distribution": "opensearch",

"number": "2.6.0"

},

"tagline": "The OpenSearch Project: https://opensearch.org/"

}

-

Доступ к Dashboards

Откройте в браузере:

http://localhost:5601/

Логин: admin

Пароль: указан в OPENSEARCH_INITIAL_ADMIN_PASSWORD файла docker-compose.yml

Примечания:

- Для безопасности отключается проверка хоста (

-k) при использовании демо-сертификатов

- Все команды предполагают работу в Linux-окружении

- Пароль администратора задаётся при первом запуске

Распространённые проблемы

Рассмотрите эти типичные проблемы и способы их решения, если контейнеры не запускаются или завершаются неожиданно.

Необходимость прав sudo для Docker команд

Проблема:

Требуется использовать sudo для выполнения Docker команд.

Решение:

Добавьте пользователя в группу docker:

sudo usermod -aG docker $USER

Подробнее: Post-installation steps for Linux

Ошибка: “-bash: docker-compose: command not found”

Ситуация:

При использовании Docker Desktop.

Решение:

Используйте команду без дефиса:

См. документацию Docker Compose

Ошибка: “docker: ‘compose’ is not a docker command”

Ситуация:

При использовании Docker Engine.

Решение:

Установите Docker Compose отдельно и используйте команду с дефисом:

Ошибка: “max virtual memory areas vm.max_map_count [65530] is too low”

Симптомы:

В логах сервиса появляется сообщение:

opensearch-node1 | ERROR: [1] bootstrap checks failed

opensearch-node1 | [1]: max virtual memory areas vm.max_map_count [65530] is too low...

Решение:

Увеличьте значение vm.max_map_count (см. раздел “Важные системные настройки”):

sudo sysctl -w vm.max_map_count=262144

Альтернативные способы установки

Помимо Docker, OpenSearch можно установить:

- На различные дистрибутивы Linux

- На Windows

Полные руководства: Установка и обновление OpenSearch

Дальнейшее изучение

После успешного развёртывания кластера рекомендуется изучить:

- Плагин безопасности

- Конфигурация OpenSearch

- Установка плагинов

Следующие шаги

Ознакомьтесь с разделом Взаимодействие с OpenSearch, чтобы узнать как отправлять запросы в систему.

1.2 - Взаимодействие с OpenSearch

Вы можете работать с OpenSearch через REST API или используя клиентские библиотеки для различных языков программирования.

На этой странице рассматривается REST API. Список доступных клиентов для языков программирования вы найдёте в разделе Клиенты.

REST API OpenSearch

REST API предоставляет гибкий способ взаимодействия с кластерами OpenSearch. Через API вы можете:

- Изменять настройки OpenSearch

- Управлять индексами

- Проверять состояние кластера

- Получать статистику

- И многое другое

Для отправки запросов можно использовать:

- Командную строку (cURL)

- Консоль Dev Tools в OpenSearch Dashboards

- Любой язык программирования с поддержкой HTTP-запросов

Отправка запросов через терминал

Формат запросов зависит от использования плагина безопасности.

Без плагина безопасности:

curl -X GET "http://localhost:9200/_cluster/health"

С плагином безопасности (требуются учётные данные):

curl -X GET "https://localhost:9200/_cluster/health" -ku admin:ВАШ_ПАРОЛЬ

По умолчанию:

- Логин:

admin

- Пароль: задаётся в параметре

OPENSEARCH_INITIAL_ADMIN_PASSWORD файла docker-compose.yml

Форматирование ответа:

Для удобочитаемого JSON добавьте параметр pretty:

curl -X GET "https://localhost:9200/_cluster/health?pretty"

Запросы с телом:

Укажите заголовок Content-Type и передайте данные через параметр -d:

curl -X GET "https://localhost:9200/students/_search?pretty" \

-H 'Content-Type: application/json' \

-d '{

"query": {

"match_all": {}

}

}'

Консоль Dev Tools в OpenSearch Dashboards использует упрощённый синтаксис:

- Откройте Dashboards:

https://localhost:5601/

- Перейдите: Management > Dev Tools

- Введите запрос (например):

GET _cluster/health

- Отправьте запрос:

- Клик по иконке ▶

- Ctrl+Enter (Cmd+Enter на Mac)

В документации OpenSearch запросы чаще всего приводятся в формате Dev Tools.

Дополнительно:

Индексация документов

Для добавления JSON-документа в индекс OpenSearch (индексации документа) отправьте HTTP-запрос со следующим форматом:

PUT https://<хост>:<порт>/<имя-индекса>/_doc/<идентификатор-документа>

Пример индексации документа о студенте:

PUT /students/_doc/1

{

"name": "Иван Иванов",

"gpa": 4.5,

"grad_year": 2023

}

После выполнения запроса:

- OpenSearch создаст индекс

students (если не существует)

- Сохранит документ с указанным ID (

1)

- Если ID не указан - сгенерирует его автоматически

Динамическое маппинг

OpenSearch автоматически определяет типы полей на основе JSON-структуры документа.

Просмотр схемы полей:

GET /students/_mapping

Пример ответа:

{

"students": {

"mappings": {

"properties": {

"gpa": {"type": "float"},

"grad_year": {"type": "long"},

"name": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

}

}

}

}

}

Особенности типов:

- Числовые значения:

float, long

- Текстовые поля:

- Основное поле (

text): для полнотекстового поиска (с анализом)

- Подполе (

keyword): для точного поиска по терминам

Важно: Для изменения типов (например, преобразования grad_year в дату) требуется пересоздание индекса с явным указанием маппинга.

Поиск документов

Базовый запрос (возвращает все документы):

GET /students/_search

{

"query": {

"match_all": {}

}

}

Пример ответа:

{

"took": 12,

"hits": {

"total": {

"value": 1,

"relation": "eq"

},

"hits": [

{

"_index": "students",

"_id": "1",

"_score": 1,

"_source": {

"name": "Иван Иванов",

"gpa": 4.5,

"grad_year": 2023

}

}

]

}

}

Ключевые элементы ответа:

took: время выполнения (мс)hits.total: количество найденных документовhits.hits: массив результатов_score: релевантность документа

Дополнительные материалы:

Обновление документов

В OpenSearch документы неизменяемы, но их можно обновить, полностью заменив содержимое или изменив отдельные поля.

Полное обновление (переиндексация)

Используйте Index Document API для полного обновления:

PUT /students/_doc/1

{

"name": "Иван Иванов",

"gpa": 4.7, // Обновлённое значение

"grad_year": 2023,

"address": "ул. Ленина, 123" // Новое поле

}

Частичное обновление

Используйте Update Document API для изменения отдельных полей:

POST /students/_update/1/

{

"doc": {

"gpa": 4.7,

"address": "ул. Ленина, 123"

}

}

Удаление данных

Удаление документа

Удаление индекса

Настройка индексов

Маппинги и параметры

Индексы настраиваются через:

- Маппинги - определяют типы полей

- Параметры - настройки индекса (количество шардов и т.д.)

Пример создания индекса с явными настройками:

PUT /students

{

"settings": {

"index.number_of_shards": 1

},

"mappings": {

"properties": {

"name": {"type": "text"},

"grad_year": {"type": "date"}

}

}

}

Проверка маппинга:

Важно:

- Типы полей нельзя изменить после создания

- Для изменения требуется пересоздание индекса

Дополнительные материалы

Следующие шаги

Ознакомьтесь с разделом Загрузка данных в OpenSearch для изучения способов импорта данных.

1.3 - Загрузка данных в OpenSearch

Добавление отдельных документов. Массовая загрузка документов. Использование Data Prepper.

Существует несколько способов импорта данных:

-

Добавление отдельных документов

См. раздел Индексация документов

-

Массовая загрузка документов

См. раздел Пакетная индексация

-

Использование Data Prepper

Серверного сборщика данных OpenSearch для обработки перед анализом

-

Другие инструменты

См. Инструменты OpenSearch

Пакетная индексация

Для массовой загрузки используйте Bulk API:

POST _bulk

{ "create": { "_index": "students", "_id": "2" } }

{ "name": "Алексей Петров", "gpa": 4.2, "grad_year": 2025 }

{ "create": { "_index": "students", "_id": "3" } }

{ "name": "Мария Смирнова", "gpa": 4.8, "grad_year": 2024 }

Работа с тестовыми данными

OpenSearch предоставляет демонстрационный набор данных электронной коммерции.

Шаги для создания тестового индекса:

-

Скачайте файлы:

# Маппинг полей

curl -O https://raw.githubusercontent.com/.../ecommerce-field_mappings.json

# Данные для загрузки

curl -O https://raw.githubusercontent.com/.../ecommerce.ndjson

-

Примените схему полей:

curl -H "Content-Type: application/json" -X PUT "https://localhost:9200/ecommerce" \

-ku admin:ПАРОЛЬ --data-binary "@ecommerce-field_mappings.json"

-

Загрузите данные:

curl -H "Content-Type: application/x-ndjson" -X POST "https://localhost:9200/ecommerce/_bulk" \

-ku admin:ПАРОЛЬ --data-binary "@ecommerce.ndjson"

Пример поиска:

GET ecommerce/_search

{

"query": {

"match": {

"customer_first_name": "Светлана"

}

}

}

Визуализация данных

Инструкции по работе с визуализациями см. в руководстве по OpenSearch Dashboards.

Дополнительные материалы

Следующие шаги

Изучите раздел Поиск по данным для получения информации о возможностях поиска.

1.4 - Поиск данных в OpenSearch

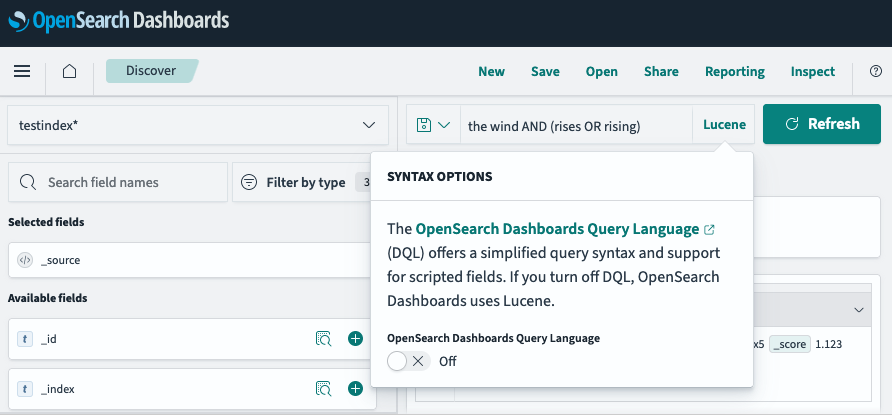

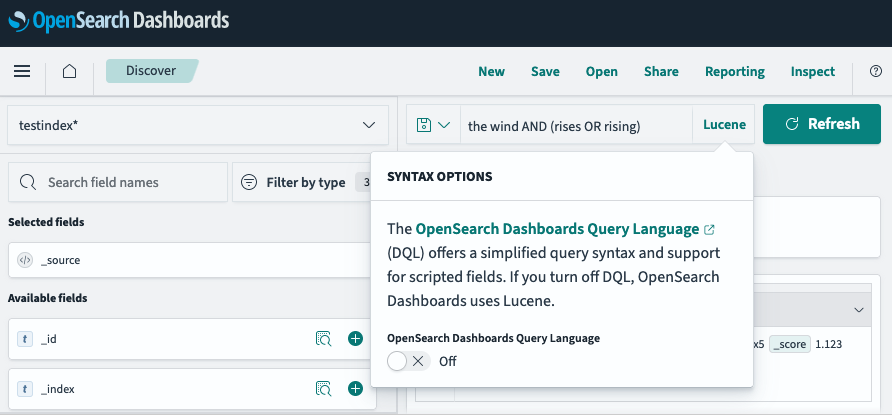

OpenSearch предлагает несколько методов поиска: Query DSL, Query string, SQL, PPL, DQL

OpenSearch предлагает несколько методов поиска:

- Query DSL - основной язык запросов для сложных поисковых сценариев

- Query string - упрощённый синтаксис для параметров запроса

- SQL - традиционный язык запросов для реляционных данных

- PPL (Piped Processing Language) - язык для задач observability

- DQL (Dashboards Query Language) - текстовый язык фильтрации в Dashboards

Подготовка данных

Перед началом загрузим тестовые данные о студентах:

POST _bulk

{ "create": { "_index": "students", "_id": "1" } }

{ "name": "Иван Петров", "gpa": 4.5, "grad_year": 2023}

{ "create": { "_index": "students", "_id": "2" } }

{ "name": "Алексей Смирнов", "gpa": 4.2, "grad_year": 2025 }

{ "create": { "_index": "students", "_id": "3" } }

{ "name": "Мария Иванова", "gpa": 4.8, "grad_year": 2024 }

Базовые запросы

Получение всех документов:

Эквивалентно:

GET /students/_search

{

"query": { "match_all": {} }

}

Структура ответа:

took - время выполнения (мс)timed_out - флаг превышения таймаута_shards - статистика по шардамhits - результаты поиска:

total - общее количество совпаденийmax_score - максимальная релевантностьhits - массив документов с оценкой релевантности

Query string поиск

Пример поиска по имени:

GET /students/_search?q=name:john

вернет ответ:

{

"took": 18,

"timed_out": false,

"_shards": {

"total": 1,

"successful": 1,

"skipped": 0,

"failed": 0

},

"hits": {

"total": {

"value": 1,

"relation": "eq"

},

"max_score": 0.9808291,

"hits": [

{

"_index": "students",

"_id": "1",

"_score": 0.9808291,

"_source": {

"name": "John Doe",

"grade": 12,

"gpa": 3.89,

"grad_year": 2022,

"future_plans": "John plans to be a computer science major"

}

}

]

}

}

Полнотекстовый поиск (Query DSL)

Поиск с анализом текста:

GET /students/_search

{

"query": {

"match": {

"name": "иван" # Найдёт "Иван Петров" и "Мария Иванова"

}

}

}

{

"took": 13,

"timed_out": false,

"_shards": {

"total": 1,

"successful": 1,

"skipped": 0,

"failed": 0

},

"hits": {

"total": {

"value": 1,

"relation": "eq"

},

"max_score": 0.9808291,

"hits": [

{

"_index": "students",

"_id": "1",

"_score": 0.9808291,

"_source": {

"name": "Иван Петров",

"gpa": 3.89,

"grad_year": 2022

}

}

]

}

}

Поиск по ключевым словам

Точное совпадение (без анализа):

GET /students/_search

{

"query": {

"match": {

"name.keyword": "john doe" # Только полное совпадение

}

}

}

{

"took": 19,

"timed_out": false,

"_shards": {

"total": 1,

"successful": 1,

"skipped": 0,

"failed": 0

},

"hits": {

"total": {

"value": 1,

"relation": "eq"

},

"max_score": 0.9808291,

"hits": [

{

"_index": "students",

"_id": "1",

"_score": 0.9808291,

"_source": {

"name": "John Doe",

"gpa": 3.89,

"grad_year": 2022

}

}

]

}

}

Фильтры

Точное значение:

GET students/_search

{

"query": {

"bool": {

"filter": [

{ "term": { "grad_year": 2023 }}

]

}

}

}

Диапазон значений:

GET students/_search

{

"query": {

"bool": {

"filter": [

{ "range": { "gpa": { "gt": 4.0 }}}

]

}

}

}

Составные запросы

Комбинация условий:

GET students/_search

{

"query": {

"bool": {

"must": [

{ "match": { "name": "иван" } },

{ "range": { "gpa": { "gte": 4.0 } } },

{ "term": { "grad_year": 2023 }}

]

}

}

}

Расширенные возможности

OpenSearch поддерживает современные методы поиска:

- k-NN (поиск ближайших соседей)

- Семантический поиск

- Мультимодальный поиск

- Гибридный поиск

Дополнительные материалы

1.5 - Начало работы с безопасностью в OpenSearch

Демонстрационная конфигурация безопасности и настройка демонстрационной конфигурации

Демонстрационная конфигурация безопасности

Наиболее простой способ начать работу с безопасностью OpenSearch - использовать демонстрационную конфигурацию. OpenSearch включает полезные скрипты, в том числе:

install_demo_configuration.sh (для Linux/macOS)install_demo_configuration.bat (для Windows)

Расположение скрипта:

plugins/opensearch-security/tools/

Действия скрипта:

- Создает демонстрационные сертификаты для TLS-шифрования на транспортном и REST-уровнях

- Настраивает тестовых пользователей, роли и привязки ролей

- Конфигурирует плагин безопасности для использования внутренней базы данных аутентификации

- Обновляет

opensearch.yml базовой конфигурацией для запуска кластера

Важно! Демонстрационные сертификаты и пароли по умолчанию не должны использоваться в production. Перед развертыванием в продакшене их необходимо заменить на собственные.

Настройка демонстрационной конфигурации

Перед запуском скрипта:

- Установите переменную окружения с надежным паролем администратора:

export OPENSEARCH_INITIAL_ADMIN_PASSWORD=<ваш_надежный_пароль>

- Проверьте надежность пароля с помощью инструмента Zxcvbn

Запуск скрипта:

./plugins/opensearch-security/tools/install_demo_configuration.sh

Проверка конфигурации:

curl -k -XGET -u admin:<пароль> https://<ip-opensearch>:9200

Ожидаемый ответ:

{

"name": "smoketestnode",

"cluster_name": "opensearch",

"version": {

"distribution": "opensearch",

"number": "2.13.0"

},

"tagline": "The OpenSearch Project: https://opensearch.org/"

}

Настройка OpenSearch Dashboards

Добавьте в opensearch_dashboards.yml следующую конфигурацию:

opensearch.hosts: [https://localhost:9200]

opensearch.ssl.verificationMode: none

opensearch.username: kibanaserver

opensearch.password: kibanaserver

opensearch.requestHeadersWhitelist: [authorization, securitytenant]

opensearch_security.multitenancy.enabled: true

opensearch_security.multitenancy.tenants.preferred: [Private, Global]

opensearch_security.readonly_mode.roles: [kibana_read_only]

opensearch_security.cookie.secure: false # Отключено для HTTP

Запуск Dashboards:

yarn start --no-base-path

После запуска в логах появятся строки:

[info][listening] Server running at http://localhost:5601

[info][server][OpenSearchDashboards][http] http server running at http://localhost:5601

Доступ через браузер: http://localhost:5601

Логин: admin

Пароль: значение из OPENSEARCH_INITIAL_ADMIN_PASSWORD

Управление пользователями и ролями

1. Добавление пользователей

Способы:

- Редактирование

internal_users.yml

- Использование API

- Через интерфейс OpenSearch Dashboards

Пример добавления пользователя в internal_users.yml:

test-user:

hash: "$2y$12$CkxFoTAJKsZaWv/m8VoZ6ePG3DBeBTAvoo4xA2P21VCS9w2RYumsG"

backend_roles:

- "test-backend-role"

- "kibanauser"

description: "Тестовый пользователь"

Генерация хеша пароля:

./plugins/opensearch-security/tools/hash.sh

Введите пароль (например, secretpassword), скопируйте полученный хеш.

2. Создание ролей

Формат roles.yml:

<имя_роли>:

cluster_permissions:

- <разрешение_кластера>

index_permissions:

- index_patterns:

- <шаблон_индекса>

allowed_actions:

- <разрешения_индекса>

Пример роли для доступа к индексу:

human_resources:

index_permissions:

- index_patterns:

- "humanresources"

allowed_actions:

- "READ"

3. Привязка пользователей к ролям

Формат roles_mapping.yml:

<имя_роли>:

users:

- <имя_пользователя>

backend_roles:

- <имя_роли>

Пример привязки:

human_resources:

backend_roles:

- "test-backend-role"

kibana_user:

backend_roles:

- "kibanauser"

Применение изменений конфигурации

После изменения файлов необходимо загрузить конфигурацию в security index:

./plugins/opensearch-security/tools/securityadmin.sh \

-cd "config/opensearch-security" \

-icl \

-key "../kirk-key.pem" \

-cert "../kirk.pem" \

-cacert "../root-ca.pem" \

-nhnv

Дальнейшие шаги

- Ознакомьтесь с Рекомендациями по безопасности OpenSearch

- Изучите Обзор конфигурации безопасности для кастомизации под ваши задачи

Примечания:

- Все команды предполагают выполнение из корневой директории OpenSearch

- Для production-окружений обязательно замените демонстрационные сертификаты

- Регулярно обновляйте пароли администраторов

1.6 - Основные концепции OpenSearch

Полное руководство по OpenSearch: документы, индексы, шарды, узлы кластера, текстовый анализ и жизненный цикл данных. Узнайте, как работают индексация, поиск и агрегация в распределенной поисковой системе.

Базовые понятия

Документ

Базовая единица информации в OpenSearch, хранимая в формате JSON. Представляет собой структурированные данные в виде пар “ключ-значение”.

Индекс

Коллекция логически связанных документов. Аналог таблицы в реляционных БД.

JSON (JavaScript Object Notation)

Текстовый формат для хранения данных, использующий структуру ключ-значение. Основной формат представления данных в OpenSearch.

Маппинг

Схема индекса, определяющая:

- Типы полей документов

- Способы индексации и хранения

- Параметры анализа текста

Архитектура кластера

Узел (Node)

Отдельный сервер, являющийся частью кластера OpenSearch.

Кластер

Совокупность узлов, работающих как единая система.

Управляющий узел (Cluster Manager)

Специальный узел, координирующий кластерные операции:

- Создание/удаление индексов

- Балансировка нагрузки

- Мониторинг состояния узлов

Шард (Shard)

Часть индекса, содержащая подмножество его данных. Индексы разделяются на шарды для:

- Горизонтального масштабирования

- Распределения нагрузки

Типы шардов:

- Первичный (Primary) - основной шард с данными

- Реплика (Replica) - копия первичного шарда для:

- Отказоустойчивости

- Повышения производительности поиска

Структуры данных и хранение

Doc Values

Оптимизированная on-disk структура для:

- Сортировки

- Агрегации

- Доступа к значениям полей

Инвертированный индекс

Структура данных, отображающая термины на документы, которые их содержат. Основа полнотекстового поиска.

Lucene

Библиотека поиска, лежащая в основе OpenSearch. Отвечает за:

- Индексацию

- Хранение

- Поиск данных

Сегмент (Segment)

Неизменяемая единица хранения данных внутри шарда. Особенности:

- Создается при операции refresh

- Объединяется в процессе merge

- Оптимизирован для быстрого поиска

Операции с данными

Ингestion

Процесс добавления данных в OpenSearch. Включает:

- Прием данных

- Парсинг

- Подготовку к индексации

Индексация

Процесс организации данных для эффективного поиска:

- Анализ текста

- Построение инвертированного индекса

- Хранение документов

Пакетная индексация

Массовая загрузка документов через Bulk API:

- Высокая производительность

- Минимизация сетевых издержек

- Атомарность операций

Анализ текста

Текстовый анализ

Процесс преобразования неструктурированного текста в последовательность терминов для индексации.

Компоненты анализатора:

-

Character Filter

Обрабатывает сырой текст:

- Удаление/замена символов

- HTML-разметка

-

Tokenizer

Разбивает текст на токены (слова) с метаданными:

-

Token Filter

Модифицирует токены:

- Приведение к нижнему регистру

- Удаление стоп-слов

- Добавление синонимов

- Стемминг

Типы анализаторов:

Стемминг

Приведение слов к базовой форме (например: “running” → “run”)

Поиск и запросы

Типы запросов:

- Query DSL - основной язык сложных запросов

- Query String - упрощенный синтаксис для URL

- DQL - язык фильтрации в Dashboards

- PPL - язык для observability с pipe-синтаксисом

Контексты выполнения:

Типы поиска:

Агрегации

Механизм анализа и суммирования данных:

- Метрики (avg, sum)

- Бакетизация (histogram, date_histogram)

- Вложенные агрегации

Жизненный цикл обновлений

-

Транзакционный лог (translog)

- Операция записывается в translog

- Гарантия durability через fsync

- Подтверждение клиенту

-

In-memory буфер

- Данные добавляются в буфер Lucene

- Еще не видны для поиска

-

Refresh

- Сброс буфера в сегменты

- Данные становятся видимыми для поиска

- Без гарантии durability

-

Flush

- Запись сегментов на диск (fsync)

- Очистка translog

- Гарантия сохранности данных

-

Merge

- Объединение мелких сегментов

- Оптимизация:

- Уменьшение количества файлов

- Освобождение места

- Улучшение производительности

Критические операции

Translog

Журнал операций для гарантии сохранности данных. Особенности:

- Записывается синхронно перед подтверждением

- Ограничен по размеру

- Очищается после flush

Refresh

Периодическая операция (по умолчанию каждые 1с):

- Делает данные доступными для поиска

- Создает новые сегменты

- Не гарантирует сохранность при сбое

Flush

Операция записи на диск:

- Обеспечивает durability

- Выполняется автоматически при:

- Достижении лимита translog

- Плановом обслуживании

Merge

Фоновая оптимизация:

- Управляется политикой слияния

- Регулирует:

- Частоту слияний

- Максимальный размер сегментов

- Параллелизм операций

2 - Install and upgrade OpenSearch

OpenSearch и OpenSearch Dashboards доступны на любом совместимом хосте, который поддерживает Docker

OpenSearch и OpenSearch Dashboards доступны на любом совместимом хосте, который поддерживает Docker (таких как Linux, MacOS или Windows). Кроме того, вы можете установить оба продукта на различных дистрибутивах Linux и на Windows.

Скачайте OpenSearch для вашей предпочтительной платформы, а затем выберите один из следующих руководств по установке.

| OpenSearch |

OpenSearch Dashboards |

| Docker |

Docker |

| Helm |

Helm |

| Tarball |

Tarball |

| RPM |

RPM |

| Debian |

Debian |

| Ansible playbook |

|

| Windows |

Windows |

После установки OpenSearch ознакомьтесь с его настройкой для вашего развертывания.

Для получения дополнительной информации об обновлении вашего кластера OpenSearch смотрите руководство по обновлению.

Для информации об инструментах обновления смотрите инструменты обновления, миграции и сравнения OpenSearch.

Для установки плагинов смотрите раздел Установка плагинов.

2.1 - Установка OpenSearch

В этом разделе представлена информация о том, как установить OpenSearch на вашем хосте, включая порты, которые необходимо открыть, и важные настройки, которые нужно сконфигурировать на вашем хосте.

Рекомендации по файловой системе

Избегайте использования сетевой файловой системы для хранения узлов в рабочем процессе в производственной среде. Использование сетевой файловой системы для хранения узлов может вызвать проблемы с производительностью в вашем кластере из-за таких факторов, как условия сети (например, задержка или ограниченная пропускная способность) или скорости чтения/записи. Вам следует использовать твердотельные накопители (SSD), установленные на хосте, для хранения узлов, где это возможно.

Совместимость с Java

Распределение OpenSearch для Linux поставляется с совместимой версией JDK Adoptium Java в каталоге jdk. Чтобы узнать версию JDK, выполните команду ./jdk/bin/java -version. Например, архив OpenSearch 1.0.0 поставляется с Java 15.0.1+9 (не LTS), OpenSearch 1.3.0 поставляется с Java 11.0.14.1+1 (LTS), а OpenSearch 2.0.0 поставляется с Java 17.0.2+8 (LTS). OpenSearch тестируется со всеми совместимыми версиями Java.

| Версия OpenSearch |

Совместимые версии Java |

Встроенная версия Java |

| 1.0–1.2.x |

11, 15 |

15.0.1+9 |

| 1.3.x |

8, 11, 14 |

11.0.25+9 |

| 2.0.0–2.11.x |

11, 17 |

17.0.2+8 |

| 2.12.0+ |

11, 17, 21 |

21.0.5+11 |

Чтобы использовать другую установку Java, установите переменную окружения OPENSEARCH_JAVA_HOME или JAVA_HOME на расположение установки Java. Например:

export OPENSEARCH_JAVA_HOME=/path/to/opensearch-3.1.0/jdk

Сетевые требования

Следующие порты необходимо открыть для компонентов OpenSearch.

| Номер порта |

Компонент OpenSearch |

| 443 |

OpenSearch Dashboards в AWS OpenSearch Service с шифрованием в пути (TLS) |

| 5601 |

OpenSearch Dashboards |

| 9200 |

OpenSearch REST API |

| 9300 |

Внутреннее взаимодействие узлов и транспорт, поиск по кластерам |

| 9600 |

Анализатор производительности |

Важные настройки

Для рабочих нагрузок в производственной среде убедитесь, что настройка Linux vm.max_map_count установлена как минимум на 262144. Даже если вы используете образ Docker, установите это значение на хост-машине. Чтобы проверить текущее значение, выполните следующую команду:

cat /proc/sys/vm/max_map_count

Чтобы увеличить значение, добавьте следующую строку в файл /etc/sysctl.conf:

Затем выполните команду sudo sysctl -p, чтобы перезагрузить настройки.

Для рабочих нагрузок Windows вы можете установить vm.max_map_count, выполнив следующие команды:

wsl -d docker-desktop

sysctl -w vm.max_map_count=262144

Пример файла docker-compose.yml

Файл docker-compose.yml также содержит несколько ключевых настроек:

bootstrap.memory_lock: true

Эта настройка отключает свопинг (вместе с memlock). Свопинг может значительно снизить производительность и стабильность, поэтому вы должны убедиться, что он отключен на производственных кластерах.

Включение настройки bootstrap.memory_lock заставит JVM зарезервировать всю необходимую память. Руководство по настройке сборки мусора Java SE Hotspot VM документирует резервирование 1 гигабайта (ГБ) нативной памяти для метаданных классов по умолчанию. В сочетании с кучей Java это может привести к ошибке из-за нехватки нативной памяти на ВМ с меньшим объемом памяти, чем эти требования. Чтобы предотвратить ошибки, ограничьте размер резервируемой памяти с помощью -XX:CompressedClassSpaceSize или -XX:MaxMetaspaceSize и установите размер кучи Java, чтобы убедиться, что у вас достаточно системной памяти.

OPENSEARCH_JAVA_OPTS: -Xms512m -Xmx512m

Эта настройка устанавливает размер кучи Java (рекомендуем использовать половину системной ОЗУ).

OpenSearch по умолчанию использует -Xms1g -Xmx1g для выделения памяти кучи, что имеет приоритет над конфигурациями, указанными с использованием процентной нотации (-XX:MinRAMPercentage, -XX:MaxRAMPercentage). Например, если вы установите OPENSEARCH_JAVA_OPTS=-XX:MinRAMPercentage=30 -XX:MaxRAMPercentage=70, предустановленные значения -Xms1g -Xmx1g переопределят эти настройки. При использовании OPENSEARCH_JAVA_OPTS для определения выделения памяти убедитесь, что вы используете нотацию -Xms и -Xmx.

Эта настройка устанавливает лимит в 65536 открытых файлов для пользователя OpenSearch.

Эта настройка позволяет вам получить доступ к Анализатору производительности на порту 9600.

Не объявляйте одни и те же параметры JVM в нескольких местах, так как это может привести к непредсказуемому поведению или сбою запуска службы OpenSearch. Если вы объявляете параметры JVM с помощью переменной окружения, такой как OPENSEARCH_JAVA_OPTS=-Xms3g -Xmx3g, то вам следует закомментировать любые ссылки на этот параметр JVM в config/jvm.options. Напротив, если вы определяете параметры JVM в config/jvm.options, то не следует определять эти параметры JVM с помощью переменных окружения.

Важные системные свойства

OpenSearch имеет ряд системных свойств, перечисленных в следующей таблице, которые вы можете указать в файле config/jvm.options или в переменной OPENSEARCH_JAVA_OPTS, используя нотацию аргументов командной строки -D.

| Свойство |

Описание |

opensearch.xcontent.string.length.max=<value> |

По умолчанию OpenSearch не накладывает ограничений на максимальную длину строковых полей JSON/YAML/CBOR/Smile. Чтобы защитить ваш кластер от потенциальных атак типа “отказ в обслуживании” (DDoS) или проблем с памятью, вы можете установить это свойство на разумный предел (максимум 2,147,483,647), например, -Dopensearch.xcontent.string.length.max=5000000. |

| `opensearch.xcontent.fast_double_writer=[true |

false]` |

opensearch.xcontent.name.length.max=<value> |

По умолчанию OpenSearch не накладывает ограничений на максимальную длину имен полей JSON/YAML/CBOR/Smile. Чтобы защитить ваш кластер от потенциальных DDoS или проблем с памятью, вы можете установить это свойство на разумный предел (максимум 2,147,483,647), например, -Dopensearch.xcontent.name.length.max=50000. |

opensearch.xcontent.depth.max=<value> |

По умолчанию OpenSearch не накладывает ограничений на максимальную глубину вложенности для документов JSON/YAML/CBOR/Smile. Чтобы защитить ваш кластер от потенциальных DDoS или проблем с памятью, вы можете установить это свойство на разумный предел (максимум 2,147,483,647), например, -Dopensearch.xcontent.depth.max=1000. |

opensearch.xcontent.codepoint.max=<value> |

По умолчанию OpenSearch накладывает ограничение в 52428800 на максимальный размер YAML-документов (в кодовых точках). Чтобы защитить ваш кластер от потенциальных DDoS или проблем с памятью, вы можете изменить это свойство на разумный предел (максимум 2,147,483,647). Например, -Dopensearch.xcontent.codepoint.max=5000000. |

2.1.1 - Docker

Docker значительно упрощает процесс настройки и управления вашими кластерами OpenSearch.

Docker значительно упрощает процесс настройки и управления вашими кластерами OpenSearch. Вы можете загружать официальные образы из Docker Hub или Amazon Elastic Container Registry (Amazon ECR) и быстро развернуть кластер, используя Docker Compose и любой из примеров файлов Docker Compose, включенных в этот гид. Опытные пользователи OpenSearch могут дополнительно настроить свое развертывание, создав собственный файл Docker Compose.

Контейнеры Docker являются портативными и будут работать на любом совместимом хосте, который поддерживает Docker (таких как Linux, MacOS или Windows). Портативность контейнера Docker предлагает гибкость по сравнению с другими методами установки, такими как RPM или ручная установка из Tarball, которые требуют дополнительной конфигурации после загрузки и распаковки.

Этот гид предполагает, что вы уверенно работаете с интерфейсом командной строки (CLI) Linux. Вы должны понимать, как вводить команды, перемещаться между директориями и редактировать текстовые файлы. Для получения помощи по Docker или Docker Compose обратитесь к официальной документации на их веб-сайтах.

Установка Docker и Docker Compose

Посетите страницу Get Docker для получения рекомендаций по установке и настройке Docker для вашей среды. Если вы устанавливаете Docker Engine с помощью CLI, то по умолчанию Docker не будет иметь никаких ограничений на доступные ресурсы хоста. В зависимости от вашей среды вы можете настроить ограничения ресурсов в Docker. См. раздел Runtime options with Memory, CPUs, and GPUs для получения информации.

Пользователи Docker Desktop должны установить использование памяти хоста на минимум 4 ГБ, открыв Docker Desktop и выбрав Settings → Resources.

Docker Compose — это утилита, которая позволяет пользователям запускать несколько контейнеров с одной командой. Вы передаете файл Docker Compose при его вызове. Docker Compose читает эти настройки и запускает запрашиваемые контейнеры. Docker Compose устанавливается автоматически с Docker Desktop, но пользователи, работающие в командной строке, должны установить Docker Compose вручную. Вы можете найти информацию о установке Docker Compose на официальной странице Docker Compose GitHub.

Если вам нужно установить Docker Compose вручную и ваш хост поддерживает Python, вы можете использовать pip для автоматической установки пакета Docker Compose.

Настройка важных параметров хоста

Перед установкой OpenSearch с использованием Docker настройте следующие параметры. Это самые важные настройки, которые могут повлиять на производительность ваших сервисов, но для дополнительной информации смотрите раздел о важных системных настройках.

Настройки для Linux

Для среды Linux выполните следующие команды:

-

Отключите производительность памяти с помощью свопинга для улучшения производительности:

-

Увеличьте количество доступных для OpenSearch карт памяти:

# Отредактируйте файл конфигурации sysctl

sudo vi /etc/sysctl.conf

# Добавьте строку для определения желаемого значения

# или измените значение, если ключ существует,

# а затем сохраните изменения.

vm.max_map_count=262144

# Перезагрузите параметры ядра с помощью sysctl

sudo sysctl -p

# Проверьте, что изменение было применено, проверив значение

cat /proc/sys/vm/max_map_count

Настройки для Windows

Для рабочих нагрузок Windows, использующих WSL через Docker Desktop, выполните следующие команды в терминале, чтобы установить vm.max_map_count:

wsl -d docker-desktop

sysctl -w vm.max_map_count=262144

Запуск OpenSearch в контейнере Docker

Официальные образы OpenSearch размещены на Docker Hub и Amazon ECR. Если вы хотите просмотреть образы, вы можете загружать их по отдельности, используя команду docker pull, как в следующих примерах.

Docker Hub:

docker pull opensearchproject/opensearch:3

docker pull opensearchproject/opensearch-dashboards:3

Amazon ECR:

docker pull public.ecr.aws/opensearchproject/opensearch:3

docker pull public.ecr.aws/opensearchproject/opensearch-dashboards:3

Чтобы загрузить конкретную версию OpenSearch или OpenSearch Dashboards, отличную от последней доступной версии, измените тег образа, где он упоминается (либо в командной строке, либо в файле Docker Compose). Например, opensearchproject/opensearch:3.1.0 загрузит версию OpenSearch 3.1.0. Чтобы загрузить последнюю версию, используйте opensearchproject/opensearch:latest. Обратитесь к официальным репозиториям образов для доступных версий.

Перед тем как продолжить, вы должны убедиться, что Docker работает корректно, развернув OpenSearch в одном контейнере.

Запуск OpenSearch в контейнере Docker

- Выполните следующую команду:

# Эта команда сопоставляет порты 9200 и 9600, устанавливает тип обнаружения на "single-node" и запрашивает самый новый образ OpenSearch

docker run -d -p 9200:9200 -p 9600:9600 -e "discovery.type=single-node" opensearchproject/opensearch:latest

Для OpenSearch версии 2.12 или выше установите новый пользовательский пароль администратора перед установкой, используя следующую команду:

docker run -d -p 9200:9200 -p 9600:9600 -e "discovery.type=single-node" -e "OPENSEARCH_INITIAL_ADMIN_PASSWORD=<custom-admin-password>" opensearchproject/opensearch:latest

- Отправьте запрос на порт 9200. Имя пользователя и пароль по умолчанию —

admin.

curl https://localhost:9200 -ku admin:<custom-admin-password>

Вы должны получить ответ, который выглядит следующим образом:

{

"name" : "a937e018cee5",

"cluster_name" : "docker-cluster",

"cluster_uuid" : "GLAjAG6bTeWErFUy_d-CLw",

"version" : {

"distribution" : "opensearch",

"number" : "<version>",

"build_type" : "<build-type>",

"build_hash" : "<build-hash>",

"build_date" : "<build-date>",

"build_snapshot" : false,

"lucene_version" : "<lucene-version>",

"minimum_wire_compatibility_version" : "7.10.0",

"minimum_index_compatibility_version" : "7.0.0"

},

"tagline" : "The OpenSearch Project: https://opensearch.org/"

}

- Перед остановкой работающего контейнера отобразите список всех работающих контейнеров и скопируйте идентификатор контейнера для узла OpenSearch, который вы тестируете. В следующем примере идентификатор контейнера —

a937e018cee5:

$ docker container ls

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

a937e018cee5 opensearchproject/opensearch:latest "./opensearch-docker…" 19 minutes ago Up 19 minutes 0.0.0.0:9200->9200/tcp, 9300/tcp, 0.0.0.0:9600->9600/tcp, 9650/tcp wonderful_boyd

- Остановите работающий контейнер, передав идентификатор контейнера в команду

docker stop.

docker stop <containerId>

Помните, что команда docker container ls не отображает остановленные контейнеры. Если вы хотите просмотреть остановленные контейнеры, используйте команду docker container ls -a. Вы можете удалить ненужные контейнеры вручную с помощью команды docker container rm <containerId_1> <containerId_2> <containerId_3> [...] (укажите все идентификаторы контейнеров, которые вы хотите остановить, разделенные пробелами), или, если вы хотите удалить все остановленные контейнеры, вы можете использовать более короткую команду docker container prune.

Развертывание кластера OpenSearch с использованием Docker Compose

Хотя технически возможно создать кластер OpenSearch, создавая контейнеры по одной команде за раз, гораздо проще определить вашу среду в YAML-файле и позволить Docker Compose управлять кластером. В следующем разделе содержатся примеры YAML-файлов, которые вы можете использовать для запуска предопределенного кластера с OpenSearch и OpenSearch Dashboards. Эти примеры полезны для тестирования и разработки, но не подходят для производственной среды. Если у вас нет опыта работы с Docker Compose, вам может быть полезно ознакомиться со спецификацией Docker Compose для получения рекомендаций по синтаксису и форматированию перед внесением изменений в структуры словарей в примерах.

Файл YAML, который определяет среду, называется файлом Docker Compose. По умолчанию команды docker-compose сначала проверяют вашу текущую директорию на наличие файла, который соответствует любому из следующих имен:

docker-compose.ymldocker-compose.yamlcompose.ymlcompose.yaml

Если ни один из этих файлов не существует в вашей текущей директории, команда docker-compose завершится с ошибкой.

Вы можете указать пользовательское местоположение и имя файла при вызове docker-compose с помощью флага -f:

# Используйте относительный или абсолютный путь к файлу.

docker compose -f /path/to/your-file.yml up

Если вы впервые запускаете кластер OpenSearch с использованием Docker Compose, используйте следующий пример файла docker-compose.yml. Сохраните его в домашнем каталоге вашего хоста и назовите его docker-compose.yml. Этот файл создает кластер, который содержит три контейнера: два контейнера, работающих с сервисом OpenSearch, и один контейнер, работающий с OpenSearch Dashboards. Эти контейнеры общаются через мостовую сеть под названием opensearch-net и используют два тома, по одному для каждого узла OpenSearch. Поскольку этот файл явно не отключает демонстрационную конфигурацию безопасности, устанавливаются самоподписанные TLS-сертификаты, и создаются внутренние пользователи с именами и паролями по умолчанию.

Установка пользовательского пароля администратора

Начиная с OpenSearch 2.12, для настройки демонстрационной конфигурации безопасности требуется пользовательский пароль администратора. Выполните одно из следующих действий:

-

Перед запуском docker-compose.yml установите новый пользовательский пароль администратора, используя следующую команду:

export OPENSEARCH_INITIAL_ADMIN_PASSWORD=<custom-admin-password>

-

Создайте файл .env в той же папке, что и ваш файл docker-compose.yml, с переменной OPENSEARCH_INITIAL_ADMIN_PASSWORD и значением надежного пароля.

Требования к паролям

OpenSearch по умолчанию обеспечивает высокую безопасность паролей, используя библиотеку оценки прочности паролей zxcvbn, разработанную компанией Dropbox.

Эта библиотека оценивает пароли на основе энтропии, а не жестких правил сложности, используя следующие рекомендации:

-

Сосредоточьтесь на энтропии, а не только на правилах: Вместо того чтобы просто добавлять цифры или специальные символы, придавайте приоритет общей непредсказуемости. Длинные пароли, состоящие из случайных слов или символов, обеспечивают более высокую энтропию, что делает их более безопасными, чем короткие пароли, соответствующие традиционным правилам сложности.

-

Избегайте общих шаблонов и слов из словаря: Библиотека zxcvbn обнаруживает распространенные шаблоны и слова из словаря, что помогает предотвратить использование легко угадываемых паролей.

Следуя этим рекомендациям, вы сможете создать более надежные пароли, которые обеспечат лучшую защиту ваших учетных записей и данных в OpenSearch.

Sample docker-compose.yml

services:

opensearch-node1: # This is also the hostname of the container within the Docker network (i.e. https://opensearch-node1/)

image: opensearchproject/opensearch:latest # Specifying the latest available image - modify if you want a specific version

container_name: opensearch-node1

environment:

- cluster.name=opensearch-cluster # Name the cluster

- node.name=opensearch-node1 # Name the node that will run in this container

- discovery.seed_hosts=opensearch-node1,opensearch-node2 # Nodes to look for when discovering the cluster

- cluster.initial_cluster_manager_nodes=opensearch-node1,opensearch-node2 # Nodes eligible to serve as cluster manager

- bootstrap.memory_lock=true # Disable JVM heap memory swapping

- "OPENSEARCH_JAVA_OPTS=-Xms512m -Xmx512m" # Set min and max JVM heap sizes to at least 50% of system RAM

- OPENSEARCH_INITIAL_ADMIN_PASSWORD=${OPENSEARCH_INITIAL_ADMIN_PASSWORD} # Sets the demo admin user password when using demo configuration, required for OpenSearch 2.12 and later

ulimits:

memlock:

soft: -1 # Set memlock to unlimited (no soft or hard limit)

hard: -1

nofile:

soft: 65536 # Maximum number of open files for the opensearch user - set to at least 65536

hard: 65536

volumes:

- opensearch-data1:/usr/share/opensearch/data # Creates volume called opensearch-data1 and mounts it to the container

ports:

- 9200:9200 # REST API

- 9600:9600 # Performance Analyzer

networks:

- opensearch-net # All of the containers will join the same Docker bridge network

opensearch-node2:

image: opensearchproject/opensearch:latest # This should be the same image used for opensearch-node1 to avoid issues

container_name: opensearch-node2

environment:

- cluster.name=opensearch-cluster

- node.name=opensearch-node2

- discovery.seed_hosts=opensearch-node1,opensearch-node2

- cluster.initial_cluster_manager_nodes=opensearch-node1,opensearch-node2

- bootstrap.memory_lock=true

- "OPENSEARCH_JAVA_OPTS=-Xms512m -Xmx512m"

- OPENSEARCH_INITIAL_ADMIN_PASSWORD=${OPENSEARCH_INITIAL_ADMIN_PASSWORD}

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

volumes:

- opensearch-data2:/usr/share/opensearch/data

networks:

- opensearch-net

opensearch-dashboards:

image: opensearchproject/opensearch-dashboards:latest # Make sure the version of opensearch-dashboards matches the version of opensearch installed on other nodes

container_name: opensearch-dashboards

ports:

- 5601:5601 # Map host port 5601 to container port 5601

expose:

- "5601" # Expose port 5601 for web access to OpenSearch Dashboards

environment:

OPENSEARCH_HOSTS: '["https://opensearch-node1:9200","https://opensearch-node2:9200"]' # Define the OpenSearch nodes that OpenSearch Dashboards will query

networks:

- opensearch-net

volumes:

opensearch-data1:

opensearch-data2:

networks:

opensearch-net:

Если вы переопределяете настройки opensearch_dashboards.yml, используя переменные окружения в вашем файле Compose, используйте все заглавные буквы и заменяйте точки на подчеркивания. Например, для opensearch.hosts используйте OPENSEARCH_HOSTS.

Это поведение отличается от переопределения настроек opensearch.yml, где преобразование заключается только в изменении оператора присваивания. Например, discovery.type: single-node в opensearch.yml определяется как discovery.type=single-node в docker-compose.yml.

Запуск и управление контейнерами OpenSearch с использованием Docker Compose

-

Создайте и запустите контейнеры в фоновом режиме из домашнего каталога вашего хоста (содержащего docker-compose.yml):

-

Проверьте, что сервисные контейнеры запустились корректно:

-

Если контейнер не удалось запустить, вы можете просмотреть логи сервиса:

# Если вы не укажете имя сервиса, docker compose покажет логи всех узлов

docker compose logs <serviceName>

-

Проверьте доступ к OpenSearch Dashboards, подключившись к http://localhost:5601 из браузера. Для OpenSearch версии 2.12 и выше вы должны использовать ваш настроенный логин и пароль. Для более ранних версий логин и пароль по умолчанию — admin. Мы не рекомендуем использовать эту конфигурацию на хостах, доступных из публичного интернета, пока вы не настроите конфигурацию безопасности вашего развертывания.

Помните, что localhost не может быть доступен удаленно. Если вы развертываете эти контейнеры на удаленном хосте, вам нужно установить сетевое соединение и заменить localhost на IP-адрес или DNS-запись, соответствующую хосту.

-

Остановите работающие контейнеры в вашем кластере:

Команда docker compose down остановит работающие контейнеры, но не удалит Docker-тома, которые существуют на хосте. Если вам не важны содержимое этих томов, используйте опцию -v, чтобы удалить все тома, например:

Настройка OpenSearch

В отличие от RPM-распределения OpenSearch, которое требует значительного объема конфигурации после установки, запуск кластеров OpenSearch с помощью Docker позволяет вам определить среду еще до создания контейнеров. Это возможно как при использовании Docker, так и при использовании Docker Compose.

Пример команды Docker

Рассмотрим следующую команду:

docker run \

-p 9200:9200 -p 9600:9600 \

-e "discovery.type=single-node" \

-v /path/to/custom-opensearch.yml:/usr/share/opensearch/config/opensearch.yml \

opensearchproject/opensearch:latest

Разберем каждую часть команды:

- Сопоставляет порты 9200 и 9600 (HOST_PORT:CONTAINER_PORT).

- Устанавливает

discovery.type в single-node, чтобы проверки загрузки не завершились неудачей для этого развертывания с одним узлом.

- Использует флаг

-v, чтобы передать локальный файл с именем custom-opensearch.yml в контейнер, заменяя файл opensearch.yml, включенный в образ.

- Запрашивает образ

opensearchproject/opensearch:latest из Docker Hub.

- Запускает контейнер.

Если вы сравните эту команду с примером файла docker-compose.yml, вы можете заметить некоторые общие настройки, такие как сопоставление портов и ссылка на образ. Однако эта команда только развертывает один контейнер, работающий с OpenSearch, и не создает контейнер для OpenSearch Dashboards. Более того, если вы хотите использовать пользовательские TLS-сертификаты, пользователей или роли, или определить дополнительные тома и сети, то эта “однострочная” команда быстро становится непрактичной. Вот где полезность Docker Compose становится очевидной.

Использование Docker Compose

Когда вы строите свой кластер OpenSearch с помощью Docker Compose, вам может быть проще передавать пользовательские файлы конфигурации с вашего хоста в контейнер, вместо того чтобы перечислять каждую отдельную настройку в docker-compose.yml. Аналогично тому, как в примере команды docker run был смонтирован том с хоста в контейнер с помощью флага -v, файлы Compose могут указывать тома для монтирования как подопцию для соответствующей службы. Следующий сокращенный YAML-файл демонстрирует, как смонтировать файл или директорию в контейнер:

services:

opensearch-node1:

volumes:

- opensearch-data1:/usr/share/opensearch/data

- ./custom-opensearch.yml:/usr/share/opensearch/config/opensearch.yml

opensearch-node2:

volumes:

- opensearch-data2:/usr/share/opensearch/data

- ./custom-opensearch.yml:/usr/share/opensearch/config/opensearch.yml

opensearch-dashboards:

volumes:

- ./custom-opensearch_dashboards.yml:/usr/share/opensearch-dashboards/config/opensearch_dashboards.yml

Обратите внимание, что в этом примере каждый узел OpenSearch использует один и тот же файл конфигурации, что упрощает управление настройками. Для получения более подробной информации о использовании томов и синтаксисе обратитесь к официальной документации Docker по томам.

Пример файла Docker Compose для разработки

Если вы хотите создать свой собственный файл compose на основе примера, ознакомьтесь с следующим образцом файла docker-compose.yml. Этот образец создает два узла OpenSearch и один узел OpenSearch Dashboards с отключенным плагином безопасности. Вы можете использовать этот образец в качестве отправной точки, просматривая Настройка основных параметров безопасности.

services:

opensearch-node1:

image: opensearchproject/opensearch:latest

container_name: opensearch-node1

environment:

- cluster.name=opensearch-cluster # Название кластера

- node.name=opensearch-node1 # Название узла, который будет работать в этом контейнере

- discovery.seed_hosts=opensearch-node1,opensearch-node2 # Узлы, которые будут использоваться для обнаружения кластера

- cluster.initial_cluster_manager_nodes=opensearch-node1,opensearch-node2 # Узлы, которые могут служить менеджерами кластера

- bootstrap.memory_lock=true # Отключить свопинг памяти кучи JVM

- "OPENSEARCH_JAVA_OPTS=-Xms512m -Xmx512m" # Установить минимальный и максимальный размеры кучи JVM не менее 50% от системной оперативной памяти

- "DISABLE_INSTALL_DEMO_CONFIG=true" # Предотвращает выполнение встроенного демо-скрипта, который устанавливает демо-сертификаты и конфигурации безопасности в OpenSearch

- "DISABLE_SECURITY_PLUGIN=true" # Отключает плагин безопасности

ulimits:

memlock:

soft: -1 # Установить memlock на неограниченное (без мягкого или жесткого ограничения)

hard: -1

nofile:

soft: 65536 # Максимальное количество открытых файлов для пользователя opensearch - установить не менее 65536

hard: 65536

volumes:

- opensearch-data1:/usr/share/opensearch/data # Создает том с именем opensearch-data1 и монтирует его в контейнер

ports:

- 9200:9200 # REST API

- 9600:9600 # Анализатор производительности

networks:

- opensearch-net # Все контейнеры будут присоединены к одной и той же сети Docker bridge

opensearch-node2:

image: opensearchproject/opensearch:latest

container_name: opensearch-node2

environment:

- cluster.name=opensearch-cluster # Название кластера

- node.name=opensearch-node2 # Название узла, который будет работать в этом контейнере

- discovery.seed_hosts=opensearch-node1,opensearch-node2 # Узлы, которые будут использоваться для обнаружения кластера

- cluster.initial_cluster_manager_nodes=opensearch-node1,opensearch-node2 # Узлы, которые могут служить менеджерами кластера

- bootstrap.memory_lock=true # Отключить свопинг памяти кучи JVM

- "OPENSEARCH_JAVA_OPTS=-Xms512m -Xmx512m" # Установить минимальный и максимальный размеры кучи JVM не менее 50% от системной оперативной памяти

- "DISABLE_INSTALL_DEMO_CONFIG=true" # Предотвращает выполнение встроенного демо-скрипта, который устанавливает демо-сертификаты и конфигурации безопасности в OpenSearch

- "DISABLE_SECURITY_PLUGIN=true" # Отключает плагин безопасности

ulimits:

memlock:

soft: -1 # Установить memlock на неограниченное (без мягкого или жесткого ограничения)

hard: -1

nofile:

soft: 65536 # Максимальное количество открытых файлов для пользователя opensearch - установить не менее 65536

hard: 65536

volumes:

- opensearch-data2:/usr/share/opensearch/data # Создает том с именем opensearch-data2 и монтирует его в контейнер

networks:

- opensearch-net # Все контейнеры будут присоединены к одной и той же сети Docker bridge

opensearch-dashboards:

image: opensearchproject/opensearch-dashboards:latest

container_name: opensearch-dashboards

ports:

- 5601:5601 # Привязка порта хоста 5601 к порту контейнера 5601

expose:

- "5601" # Открыть порт 5601 для веб-доступа к OpenSearch Dashboards

environment:

- 'OPENSEARCH_HOSTS=["http://opensearch-node1:9200","http://opensearch-node2:9200"]' # Указать узлы OpenSearch для Dashboards

- "DISABLE_SECURITY_DASHBOARDS_PLUGIN=true" # Отключает плагин безопасности в OpenSearch Dashboards

networks:

- opensearch-net

volumes:

opensearch-data1: {} # Создает том opensearch-data1

opensearch-data2: {} # Создает том opensearch-data2

networks:

opensearch-net: {} # Создает сеть opensearch-net

Настройка основных параметров безопасности

Перед тем как сделать ваш кластер OpenSearch доступным для внешних хостов, рекомендуется ознакомиться с конфигурацией безопасности развертывания. Вы можете вспомнить из первого примера файла docker-compose.yml, что, если не отключить плагин безопасности, установив DISABLE_SECURITY_PLUGIN=true, встроенный скрипт применит стандартную демо-конфигурацию безопасности к узлам в кластере. Поскольку эта конфигурация используется для демонстрационных целей, стандартные имена пользователей и пароли известны. Поэтому мы рекомендуем создать собственные файлы конфигурации безопасности и использовать тома для передачи этих файлов в контейнеры. Для получения конкретных рекомендаций по настройке безопасности OpenSearch смотрите Конфигурация безопасности.

Чтобы использовать свои собственные сертификаты в конфигурации, добавьте все необходимые сертификаты в раздел томов файла compose:

volumes:

- ./root-ca.pem:/usr/share/opensearch/config/root-ca.pem

- ./admin.pem:/usr/share/opensearch/config/admin.pem

- ./admin-key.pem:/usr/share/opensearch/config/admin-key.pem

- ./node1.pem:/usr/share/opensearch/config/node1.pem

- ./node1-key.pem:/usr/share/opensearch/config/node1-key.pem

Когда вы добавляете сертификаты TLS к узлам OpenSearch с помощью томов Docker Compose, вы также должны включить пользовательский файл opensearch.yml, который определяет эти сертификаты. Например:

volumes:

- ./root-ca.pem:/usr/share/opensearch/config/root-ca.pem

- ./admin.pem:/usr/share/opensearch/config/admin.pem

- ./admin-key.pem:/usr/share/opensearch/config/admin-key.pem

- ./node1.pem:/usr/share/opensearch/config/node1.pem

- ./node1-key.pem:/usr/share/opensearch/config/node1-key.pem

- ./custom-opensearch.yml:/usr/share/opensearch/config/opensearch.yml

Помните, что сертификаты, которые вы указываете в файле compose, должны совпадать с сертификатами, определенными в вашем пользовательском файле opensearch.yml. Вам следует заменить корневые, администраторские и узловые сертификаты на свои собственные. Для получения дополнительной информации смотрите Настройка сертификатов TLS.

Пример конфигурации в вашем пользовательском файле opensearch.yml может выглядеть следующим образом, добавляя сертификаты TLS и отличительное имя (DN) сертификата администратора, определяя несколько разрешений и включая подробное аудиторское логирование:

plugins.security.ssl.transport.pemcert_filepath: node1.pem

plugins.security.ssl.transport.pemkey_filepath: node1-key.pem

plugins.security.ssl.transport.pemtrustedcas_filepath: root-ca.pem

plugins.security.ssl.transport.enforce_hostname_verification: false

plugins.security.ssl.http.enabled: true

plugins.security.ssl.http.pemcert_filepath: node1.pem

plugins.security.ssl.http.pemkey_filepath: node1-key.pem

plugins.security.ssl.http.pemtrustedcas_filepath: root-ca.pem

plugins.security.allow_default_init_securityindex: true

plugins.security.authcz.admin_dn:

- CN=A,OU=UNIT,O=ORG,L=TORONTO,ST=ONTARIO,C=CA

plugins.security.nodes_dn:

- 'CN=N,OU=UNIT,O=ORG,L=TORONTO,ST=ONTARIO,C=CA'

plugins.security.audit.type: internal_opensearch

plugins.security.enable_snapshot_restore_privilege: true

plugins.security.check_snapshot_restore_write_privileges: true

plugins.security.restapi.roles_enabled: ["all_access", "security_rest_api_access"]

cluster.routing.allocation.disk.threshold_enabled: false

opendistro_security.audit.config.disabled_rest_categories: NONE

opendistro_security.audit.config.disabled_transport_categories: NONE

Полный список настроек

Для получения полного списка настроек смотрите Безопасность.

Используйте тот же процесс для указания конфигурации Backend в файле /usr/share/opensearch/config/opensearch-security/config.yml, а также для создания новых внутренних пользователей, ролей, сопоставлений, групп действий и арендаторов в соответствующих YAML-файлах.

После замены сертификатов и создания собственных внутренних пользователей, ролей, сопоставлений, групп действий и арендаторов, используйте Docker Compose для запуска кластера:

Работа с плагинами

Чтобы использовать образ OpenSearch с пользовательским плагином, вам сначала нужно создать Dockerfile. Ознакомьтесь с официальной документацией Docker для получения информации о создании Dockerfile.

FROM opensearchproject/opensearch:latest

RUN /usr/share/opensearch/bin/opensearch-plugin install --batch <pluginId>

Затем выполните следующие команды:

# Создание образа из Dockerfile

docker build --tag=opensearch-custom-plugin .

# Запуск контейнера из пользовательского образа

docker run -p 9200:9200 -p 9600:9600 -v /usr/share/opensearch/data opensearch-custom-plugin

В качестве альтернативы, вы можете удалить плагин из образа перед его развертыванием. Этот пример Dockerfile удаляет плагин безопасности:

FROM opensearchproject/opensearch:latest

RUN /usr/share/opensearch/bin/opensearch-plugin remove opensearch-security

Вы также можете использовать Dockerfile для передачи своих собственных сертификатов для использования с плагином безопасности:

FROM opensearchproject/opensearch:latest

COPY --chown=opensearch:opensearch opensearch.yml /usr/share/opensearch/config/

COPY --chown=opensearch:opensearch my-key-file.pem /usr/share/opensearch/config/

COPY --chown=opensearch:opensearch my-certificate-chain.pem /usr/share/opensearch/config/

COPY --chown=opensearch:opensearch my-root-cas.pem /usr/share/opensearch/config/

2.1.2 - Установка OpenSearch на Debian

Установка OpenSearch с использованием менеджера пакетов Advanced Packaging Tool (APT)

Установка OpenSearch с использованием менеджера пакетов Advanced Packaging Tool (APT) значительно упрощает процесс по сравнению с методом Tarball. Несколько технических аспектов, таких как путь установки, расположение конфигурационных файлов и создание службы, управляемой systemd, обрабатываются автоматически менеджером пакетов.

В общем, установка OpenSearch из дистрибутива Debian может быть разбита на несколько шагов:

- Скачать и установить OpenSearch.

- Установить вручную из Debian-пакета или из APT-репозитория.

- (Необязательно) Протестировать OpenSearch.

- Подтвердите, что OpenSearch может работать, прежде чем применять какую-либо пользовательскую конфигурацию.

- Это можно сделать без какой-либо безопасности (без пароля, без сертификатов) или с демо-конфигурацией безопасности, которая может быть применена с помощью упакованного скрипта.

- Настроить OpenSearch для вашей среды.

- Примените основные настройки к OpenSearch и начните использовать его в вашей среде.

Дистрибутив Debian предоставляет все необходимое для запуска OpenSearch внутри дистрибутивов Linux на базе Debian, таких как Ubuntu.

Этот гид предполагает, что вы уверенно работаете с интерфейсом командной строки (CLI) Linux. Вы должны понимать, как вводить команды, перемещаться между директориями и редактировать текстовые файлы. Некоторые примеры команд ссылаются на текстовый редактор vi, но вы можете использовать любой доступный текстовый редактор.

Шаг 1: Скачивание и установка OpenSearch

Установка OpenSearch из пакета

Скачайте Debian-пакет для желаемой версии непосредственно с страницы загрузок OpenSearch. Debian-пакет можно скачать как для архитектуры x64, так и для arm64.

Из командной строки установите пакет с помощью dpkg:

Для новых установок OpenSearch 2.12 и более поздних версий необходимо определить пользовательский пароль администратора для настройки демо-конфигурации безопасности. Используйте одну из следующих команд для определения пользовательского пароля администратора:

# x64

sudo env OPENSEARCH_INITIAL_ADMIN_PASSWORD=<custom-admin-password> dpkg -i opensearch-3.1.0-linux-x64.deb

# arm64

sudo env OPENSEARCH_INITIAL_ADMIN_PASSWORD=<custom-admin-password> dpkg -i opensearch-3.1.0-linux-arm64.deb

Используйте следующую команду для версий OpenSearch 2.11 и более ранних:

# x64

sudo dpkg -i opensearch-3.1.0-linux-x64.deb

# arm64

sudo dpkg -i opensearch-3.1.0-linux-arm64.deb

После успешной установки включите OpenSearch как службу:

sudo systemctl enable opensearch

Запустите службу OpenSearch:

sudo systemctl start opensearch

Проверьте, что OpenSearch запустился корректно:

sudo systemctl status opensearch

Проверка отпечатка

Debian-пакет не подписан. Если вы хотите проверить отпечаток, проект OpenSearch предоставляет файл .sig, а также пакет .deb для использования с GNU Privacy Guard (GPG).

Скачайте желаемый Debian-пакет:

curl -SLO https://artifacts.opensearch.org/releases/bundle/opensearch/3.1.0/opensearch-3.1.0-linux-x64.deb

Скачайте соответствующий файл подписи:

curl -SLO https://artifacts.opensearch.org/releases/bundle/opensearch/3.1.0/opensearch-3.1.0-linux-x64.deb.sig

Скачайте и импортируйте GPG-ключ:

curl -o- https://artifacts.opensearch.org/publickeys/opensearch-release.pgp | gpg --import -

Проверьте подпись:

gpg --verify opensearch-3.1.0-linux-x64.deb.sig opensearch-3.1.0-linux-x64.deb

Установка OpenSearch из APT-репозитория

APT, основной инструмент управления пакетами для операционных систем на базе Debian, позволяет загружать и устанавливать Debian-пакет из APT-репозитория.

- Установите необходимые пакеты:

sudo apt-get update && sudo apt-get -y install lsb-release ca-certificates curl gnupg2

- Импортируйте публичный GPG-ключ. Этот ключ используется для проверки подписи APT-репозитория:

curl -o- https://artifacts.opensearch.org/publickeys/opensearch-release.pgp | sudo gpg --dearmor --batch --yes -o /usr/share/keyrings/opensearch-release-keyring

- Создайте APT-репозиторий для OpenSearch:

echo "deb [signed-by=/usr/share/keyrings/opensearch-release-keyring] https://artifacts.opensearch.org/releases/bundle/opensearch/3.x/apt stable main" | sudo tee /etc/apt/sources.list.d/opensearch-3.x.list

- Проверьте, что репозиторий был успешно создан:

- С добавленной информацией о репозитории перечислите все доступные версии OpenSearch:

sudo apt list -a opensearch

- Выбор версии OpenSearch для установки

- Если не указано иное, будет установлена последняя доступная версия OpenSearch.

# Для новых установок OpenSearch 2.12 и более поздних версий необходимо определить пользовательский пароль администратора для настройки демо-конфигурации безопасности.

# Используйте одну из следующих команд для определения пользовательского пароля:

sudo env OPENSEARCH_INITIAL_ADMIN_PASSWORD=<custom-admin-password> apt-get install opensearch

# Для версий OpenSearch 2.11 и более ранних используйте следующую команду:

sudo apt-get install opensearch

- Установка конкретной версии OpenSearch

# Чтобы установить конкретную версию OpenSearch, укажите версию вручную, используя `opensearch=<version>`:

# Для новых установок OpenSearch 2.12 и более поздних версий: